为什么我还是无法理解 Transformer?

大家好,我是吴师兄。

写这个话题之前,特地回顾了一下我们训练营同学当初理解 Transformer 时卡壳的地方,发现这个问题很有代表性,下面我来从工程视角、优化原理和直觉比喻给你拆一拆。

大家都讲 QKV,但都跳过了「关键点」

大家可能看了无数次这个公式了:

Attention(Q,K,V)=softmax(QKT/√dk)⋅VAttention(Q, K, V) = softmax(QKᵀ / √d_k) · V

不少资料到这就结束了,然后告诉你这玩意叫“自注意力机制”,能「让每个 token 关注其他所有 token」,但:

Transformer 为什么能训练?它的 W 和 B 是怎么被反向传播更新的?

这才是让人真正“感觉它是个网络”的关键吧!

本质上 Transformer 还是神经网络,反向传播照常进行!

我们拆开来看,Transformer 是一个堆叠结构,最基本的组件是:

Input → Embedding → Multi-Head Attention → FFN → Output

其中,所有的 Linear 层都是含参数的!比如:

q_linear = nn.Linear(hidden_size, hidden_size)k_linear = nn.Linear(hidden_size, hidden_size)v_linear = nn.Linear(hidden_size, hidden_size)o_linear = nn.Linear(hidden_size, hidden_size)FFN 内的两个全连接层也是 Linear

这些层都拥有各自的 W 和 b,通过梯度反向传播自动更新。

那注意力里的 softmax 和点积怎么办?

很多人以为 Attention 只是计算了一堆系数,不能反向传播。其实完全可以!

比如这一行:

attention_scores = torch.matmul(query, key.transpose(-1, -2)) / sqrt(d_k)

这是一堆矩阵乘法 + 除法 + softmax + 加权求和操作,它们都支持梯度传播,在 PyTorch 中每一步都是可导的。

只要在训练时写的是:

loss = criterion(outputs, labels)

loss.backward()

那么:

q_linear、k_linear、v_linear、o_linear的参数都会被更新;FFN的全连接层也会被更新;整个 Attention 路径是可导的链式结构,没有断点。

换个角度理解:Attention 只是一个「带分数的加权平均」

我们用人话描述一下 Attention:

“就是拿 Q 去和每个 K 做个点积,比比“谁更相关”,然后把 V 加权平均一下,得到一个新的向量。

Q、K、V 都是从原始输入通过可训练的 Linear 层映射出来的,这些线性变换就带有权重参数 W 和偏置 b。

这整个流程,就是一个很复杂的「函数」,它也完全可以被反向传播优化。

Transformer 的训练跟 CNN 没本质区别

CNN 是卷积核滑动提取特征; RNN 是时间步递归传播状态; Transformer 是 Attention 模块进行全局信息整合。

它们都是神经网络,只不过「信息整合」的方式不同,但 都是端到端优化、都靠 loss.backward() 完成权重调整。

回答你的关键问题:

“「Transformer 的反向传播呢?如何调整权重参数?」

简单说就是:

权重来自所有的 Linear 层(Q、K、V、O、FFN) 训练过程使用的是标准的反向传播机制 每一步的算子(矩阵乘、softmax、加法)都支持链式求导 你看到的 Attention 模块,不是黑盒,而是完整参与优化的计算图的一部分

最后一点建议

我们之所以会感觉 Transformer 像「一个黑盒」,很可能是:

没看到「代码级别」的 forward + backward; 没意识到 softmax/点积这些操作也支持求导; 被太多只讲公式的文章绕晕了。

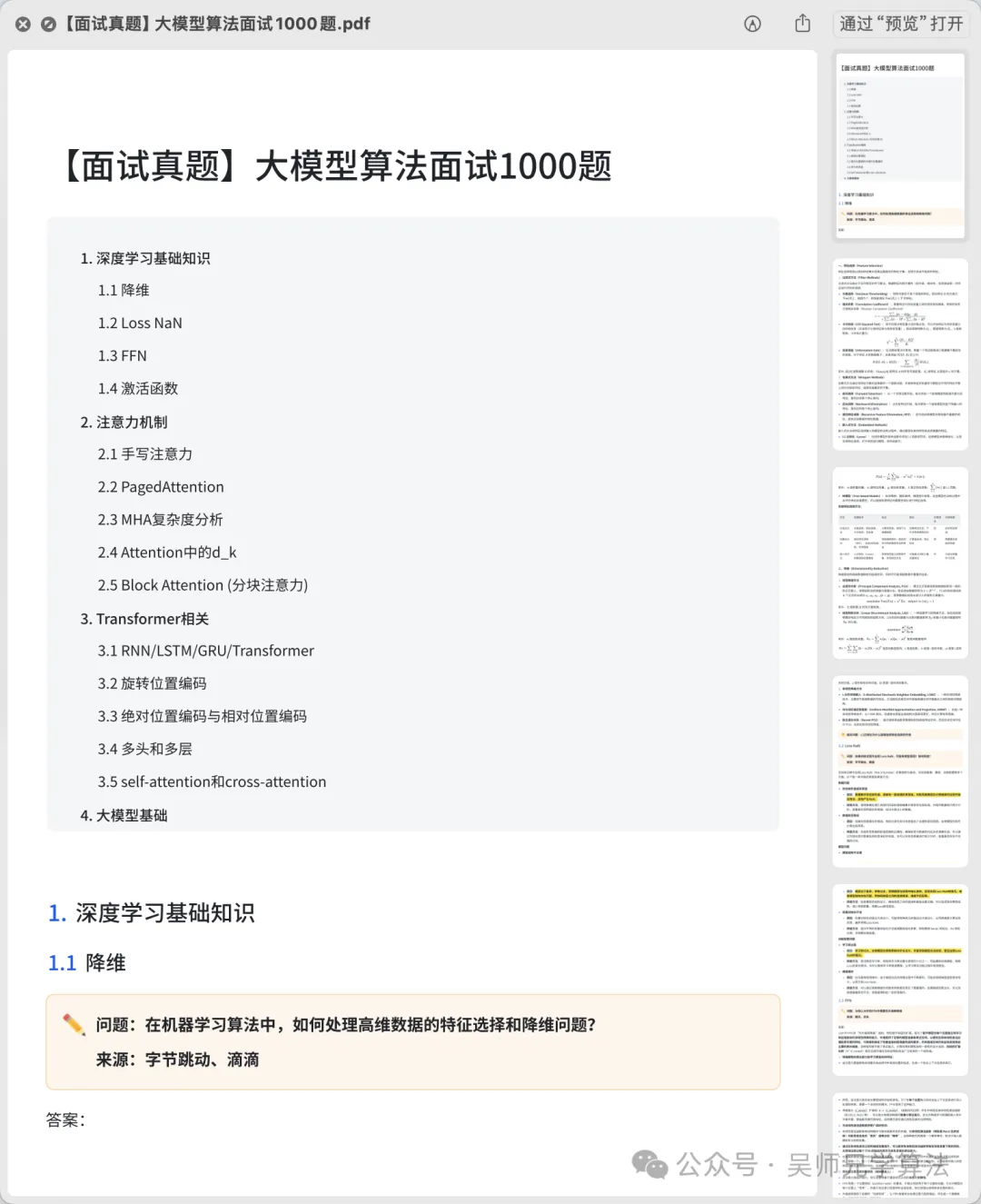

建议动手实现一个简化版的 Multi-Head Attention,比如我们训练营里常讲的这个版本(摘自 PDF):

query = self.q_linear(hidden_state)

key = self.k_linear(hidden_state)

value = self.v_linear(hidden_state)

...

attention_scores = torch.matmul(query, key.transpose(-1, -2)) / sqrt(d_k)

attention_probs = F.softmax(attention_scores, dim=-1)

output = torch.matmul(attention_probs, value)

这段代码每个 Linear 都有参数,都能梯度更新,亲测跑通后你就真理解了。

总结一句话:Transformer 本质上还是一个「全连接 + softmax + 加权平均」的神经网络,每个参数都在被优化,每一层都在被反向传播训练。不要被“注意力”三个字吓到,它没有魔法,只有矩阵计算。