MCP加持下deepseek无所不能了

原创不易,请关注公众号:【爬虫与大模型开发】,大模型的应用开发之路,整理了大模型在现在的企业级应用的实操及大家需要注意的一些AI开发的知识点!持续输出爬虫与大模型的相关文章。

一、什么是MCP?

MCP 协议 指的是 模型上下文协议 (Model Context Protocol)。 以下是关于 MCP 协议的一些关键信息:

定义: MCP 是由 Anthropic 提出的一个开放标准,旨在标准化人工智能应用程序(如聊天机器人、IDE 助手或自定义代理)与外部工具、数据源和系统之间的连接方式。你可以将其理解为 AI 集成的 USB 接口。

目标: MCP 的主要目标是简化 AI 应用程序与各种外部工具和服务集成的过程,从而解决过去需要为每种 AI 应用和工具组合构建独立集成的问题(所谓的 "M×N 问题")。通过 MCP,工具开发者只需要构建一个 MCP 服务器,而 AI 应用开发者只需要构建一个 MCP 客户端,从而将问题简化为 "M+N 问题"。

1.1 MCP帮助大模型做事

工作原理: MCP 采用客户端-服务器架构。

客户端 (MCP Client): 通常集成在用户与之交互的 AI 应用程序(Host)中,负责管理与特定 MCP 服务器的通信,包括连接管理、能力发现、请求转发和响应处理。

服务器 (MCP Server): 是 MCP 世界与外部系统(如 API、数据库、本地文件等)特定功能之间的桥梁或 API 封装器。它根据 MCP 规范暴露外部系统的能力。

核心概念:

工具 (Tools): 模型控制的功能,AI 可以调用这些功能来执行特定操作,例如调用天气 API。 资源 (Resources): 应用程序控制的数据源,类似于 REST API 中的 GET 请求,提供数据但不执行重要的计算或产生副作用。 提示 (Prompts): 用户控制的预定义模板,用于以最佳方式使用工具或资源。 通信方式: MCP 服务器和客户端主要通过以下两种方式进行通信: 标准输入/输出 (stdio): 当客户端和服务器在同一台机器上运行时使用,适用于本地集成。

通过服务器发送事件 (SSE) 的 HTTP: 客户端通过 HTTP 连接到服务器,建立持久连接后,服务器可以主动向客户端推送消息(事件)。

适用场景: MCP 主要面向需要构建自定义集成和 AI 应用程序的开发者。它适用于需要在自己的应用程序或工作流程中构建专业 AI 功能的团队。

1.2 fastapi创建自己得MCP工具

fastapi_mcp 是一个 Python 库,旨在简化将您的 FastAPI 应用程序与模型上下文协议 (Model Context Protocol, MCP) 集成的过程。简单来说,它可以帮助您轻松地将现有的 FastAPI API 接口转化为 MCP 工具,从而让支持 MCP 协议的人工智能代理和工具能够访问和使用您的 API 功能。

主要功能和特点:

自动生成 MCP 服务器: fastapi_mcp 能够以极少的配置自动将您的 FastAPI API 接口暴露为 MCP 工具。这意味着您无需进行大量手动设置,即可让 AI 代理使用您的 API。

创建自己得MCP服务

网上很多可以找点参考代码片段!

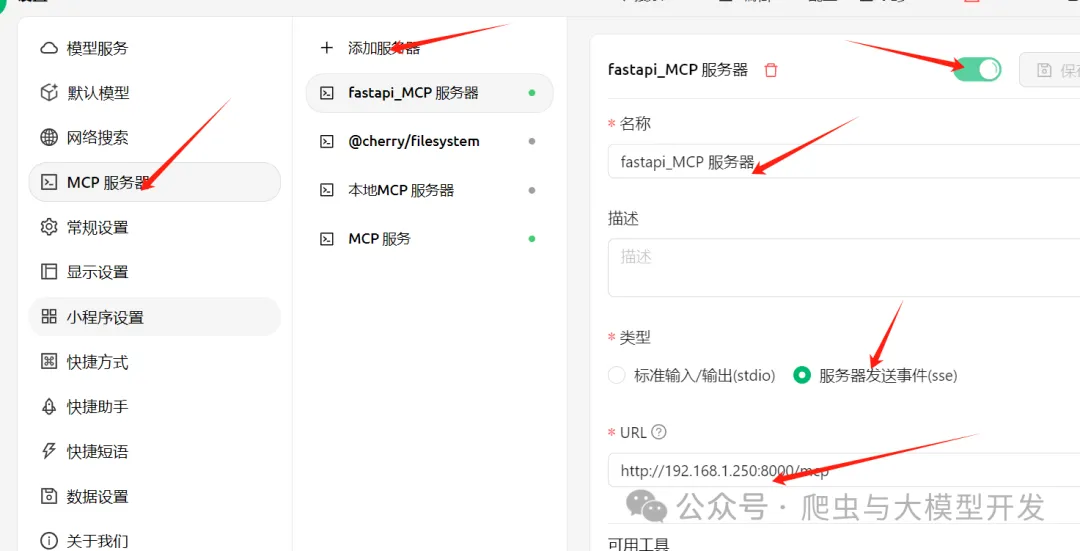

1.3 cherry studio配置MCP服务

安装cherry studio

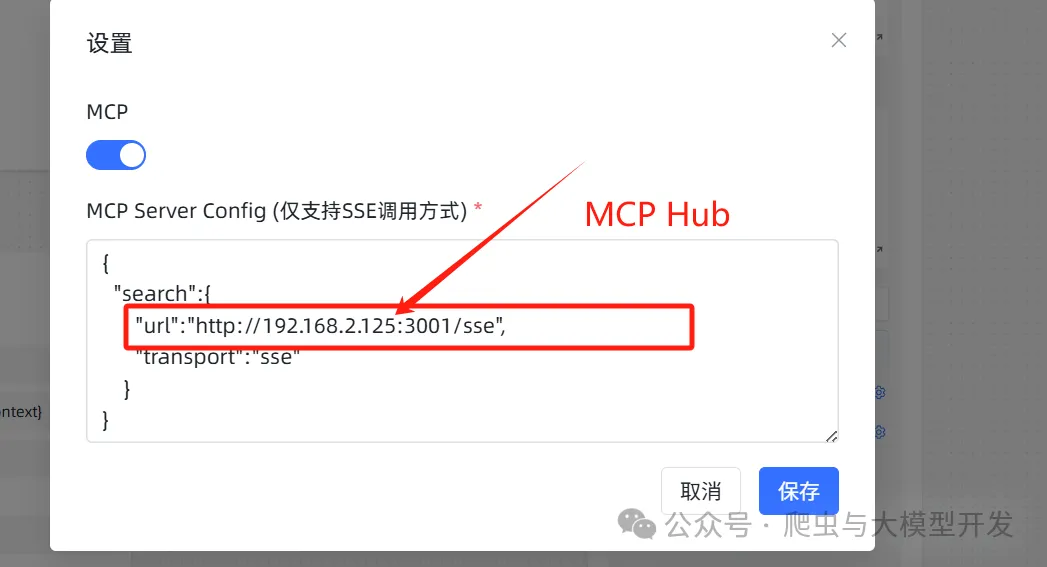

配置mcp服务

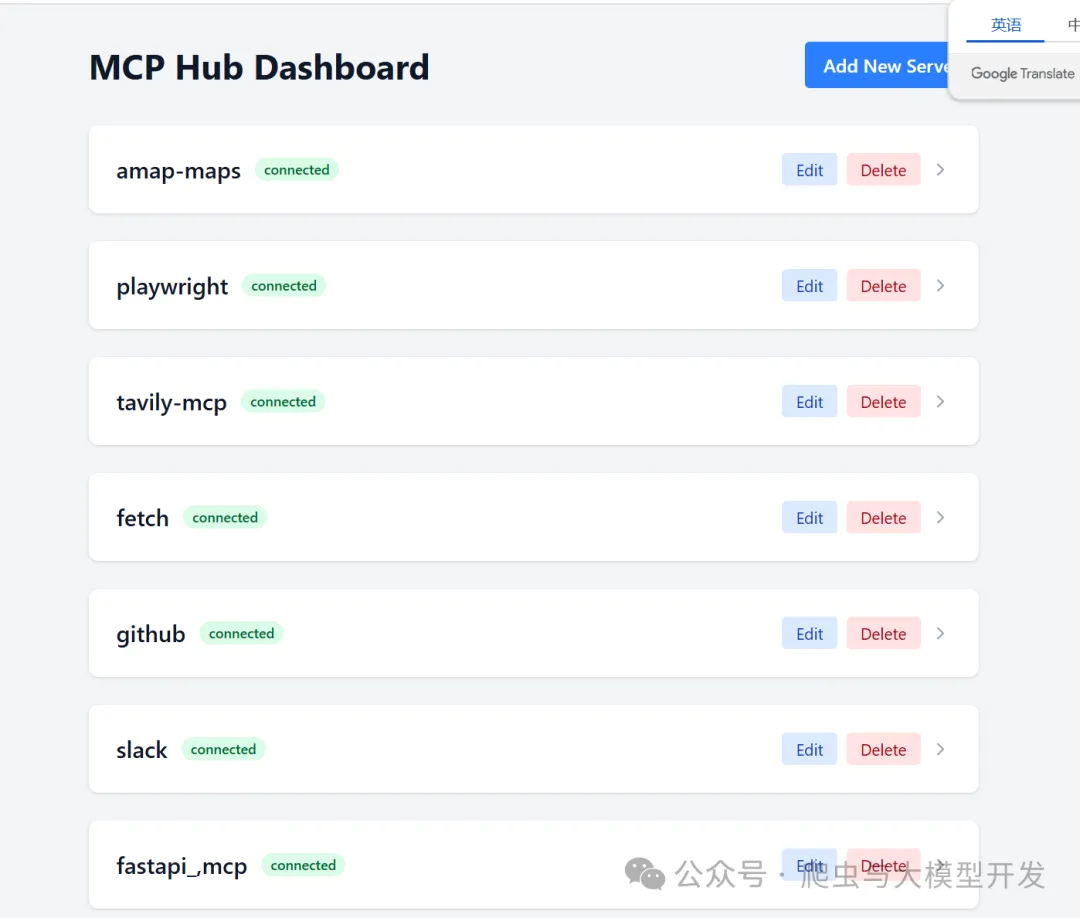

配置MCP Hub服务

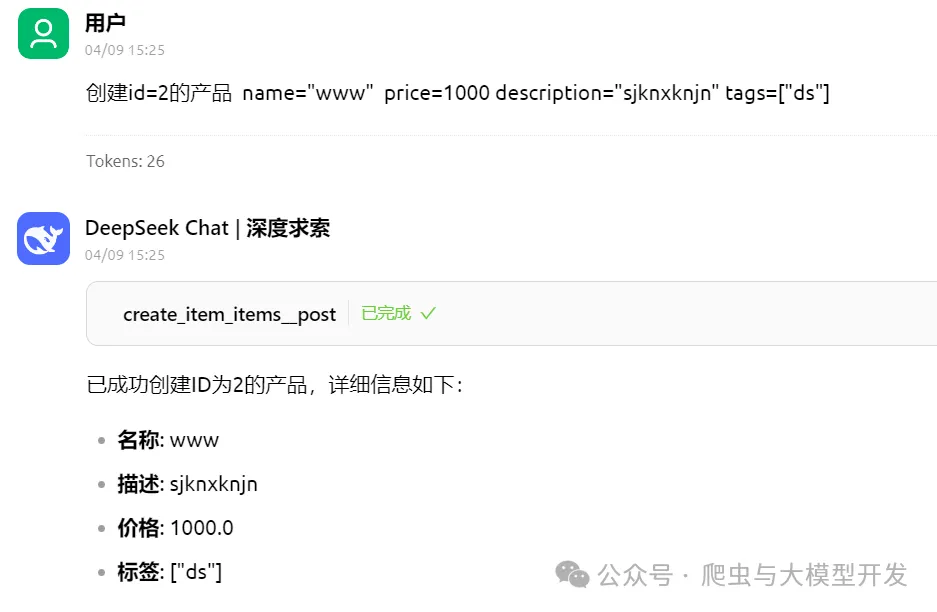

效果展示

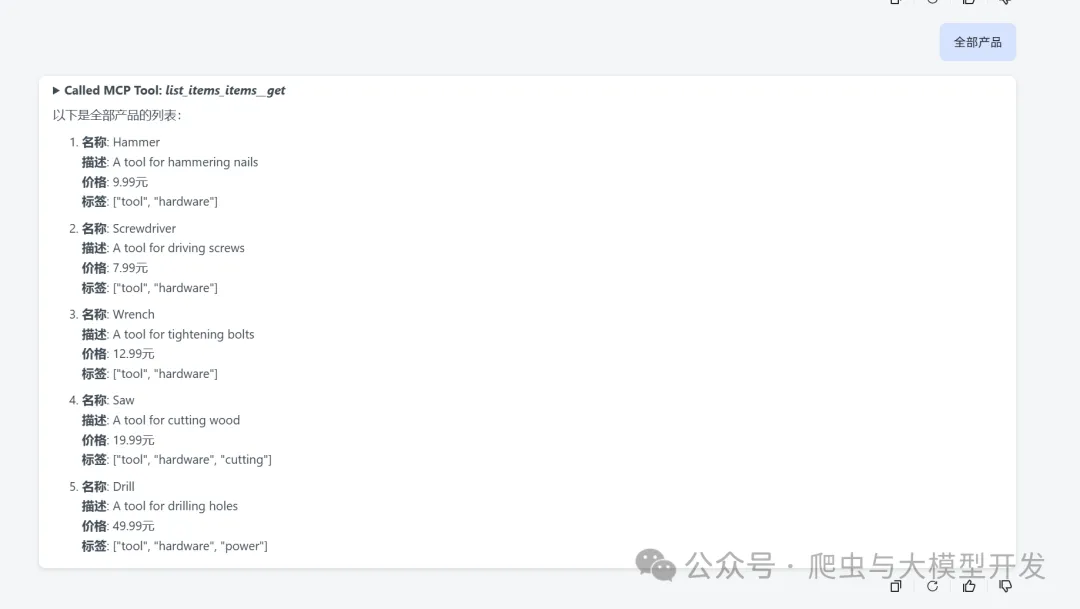

查询数据

新增数据

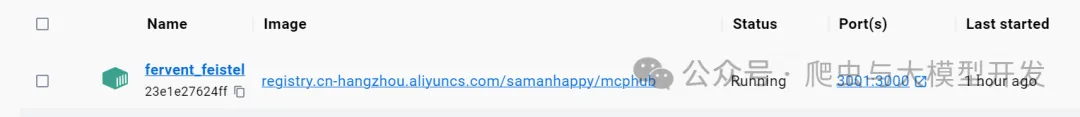

二、MCP Hub安装配置

Docker 安装MCP服务器

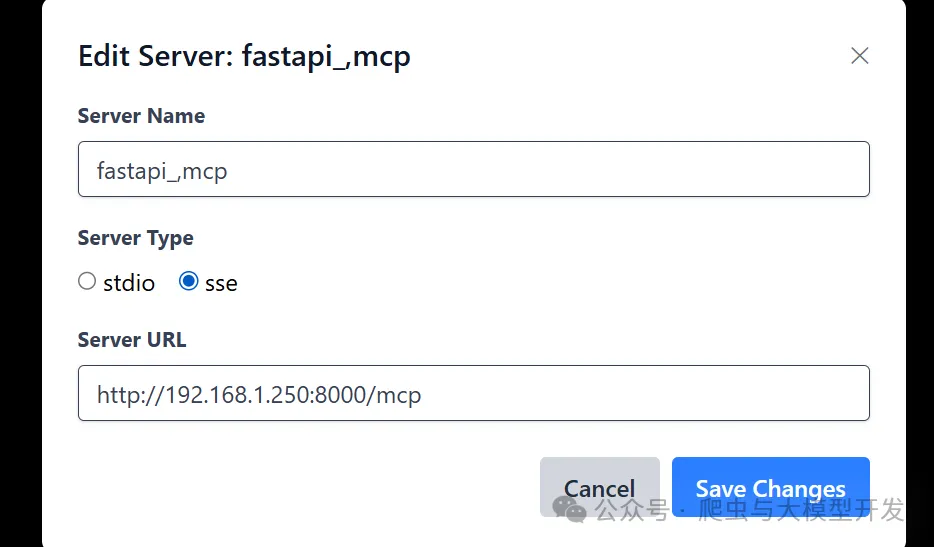

配置MCP服务

Hub 服务器 (MCP Hub): 作为中央管理服务器,连接并管理多个 MCP 服务器。它为客户端提供统一的 API 入口,并将请求路由到相应的 MCP 服务器。

2.1 MaxKb使用MCP服务

maxkb 最新的版本已经支持MCP节点和大模型MCP服务没有安装的可以自行安装

docker run -d --name=maxkb_dev --restart=always -p 8080:8080 -v D:\MaxKb_dev:/var/lib/postgresql/data

-v C:\maxkb:/opt/maxkb/app/sandbox/python-packages registry.fit2cloud.com/maxkb/maxkb

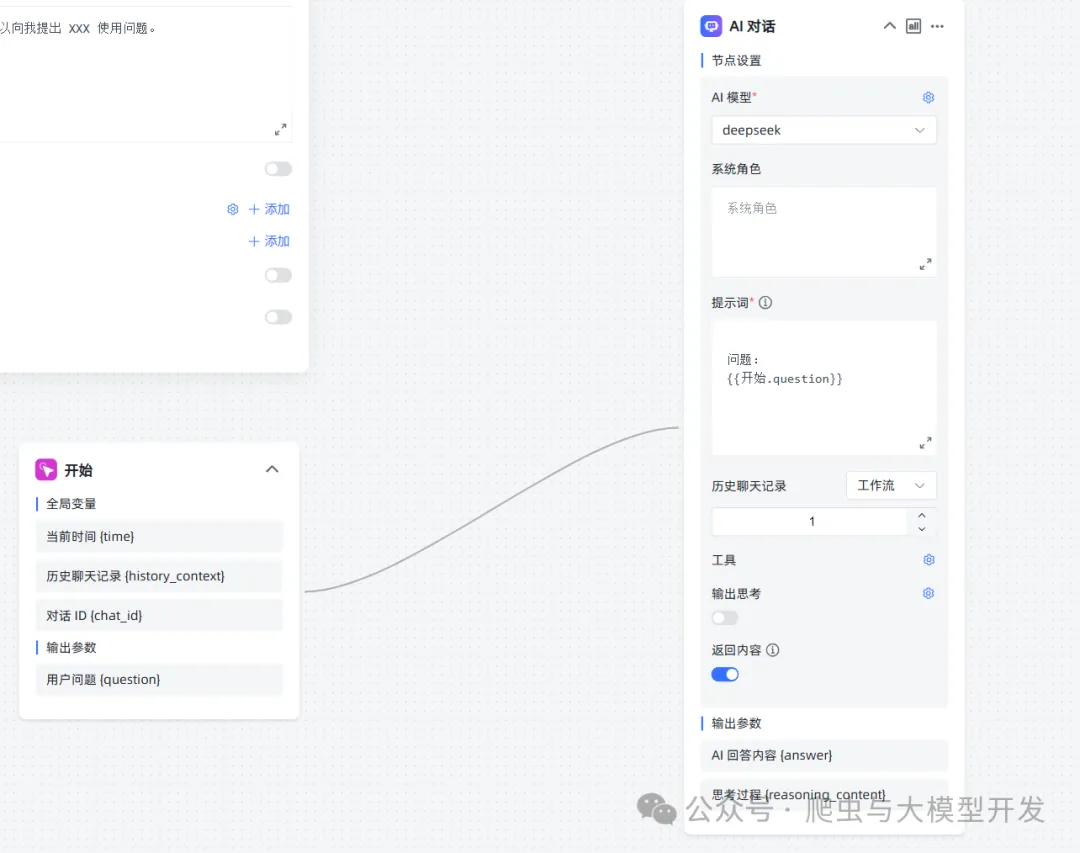

2.2 MaxKb配置MCP服务

支持的节点: 配置大模型MCP服务

配置大模型MCP服务

配置工作流测试

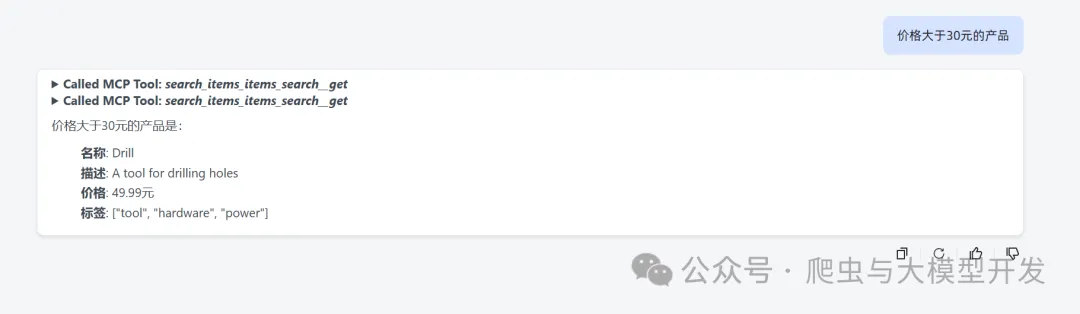

效果展示

价格大于30的产品

列出了测试数据

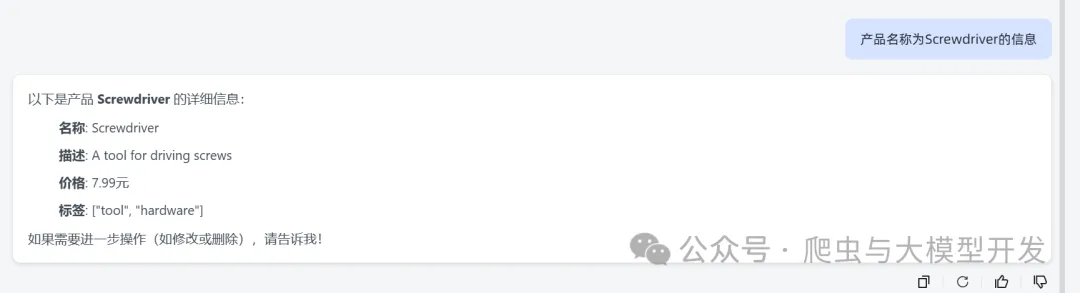

产品名称查信息

总结

总的来说,模型上下文协议 (MCP) 具有广阔的应用前景。它通过标准化 AI 应用与外部世界的连接方式,有望解决当前 AI 集成面临的诸多挑战,并推动更智能、更强大的 AI 应用的创新和发展。

联系方式

加入星球: 原创不易,点个关注! 不会错过后面的优质文章! 觉着写的不错的可以帮忙点点赞 关注公众号:【爬虫与大模型开发】 需要以上源代码的下面关注并私信!